Comments Off on Reveal Riches at Rich Casino

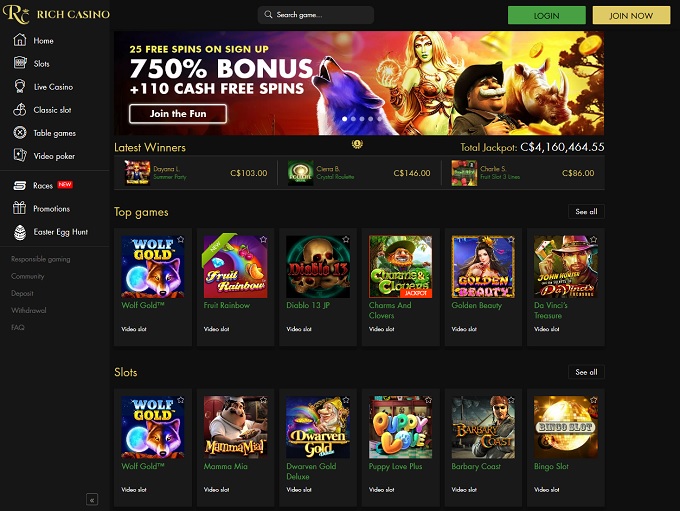

Reveal Riches at Rich Casino

Welcome to Rich Casino, where the pursuit of fortune meets the world of online gaming. Are you curious about what it has to offer? Whether you’re a seasoned player or new to the world of online casinos, Rich Casino review will provide you with insights that will enhance your gaming experience. We will delve deep into all the details and uncover the highlights of this exciting platform. From bonuses that greet you upon sign-up to the excitement of free spins, we’ll leave no stone unturned in our exploration of Rich Casino. read more

Comments Off on Brief Overview of King Chance Web Casino

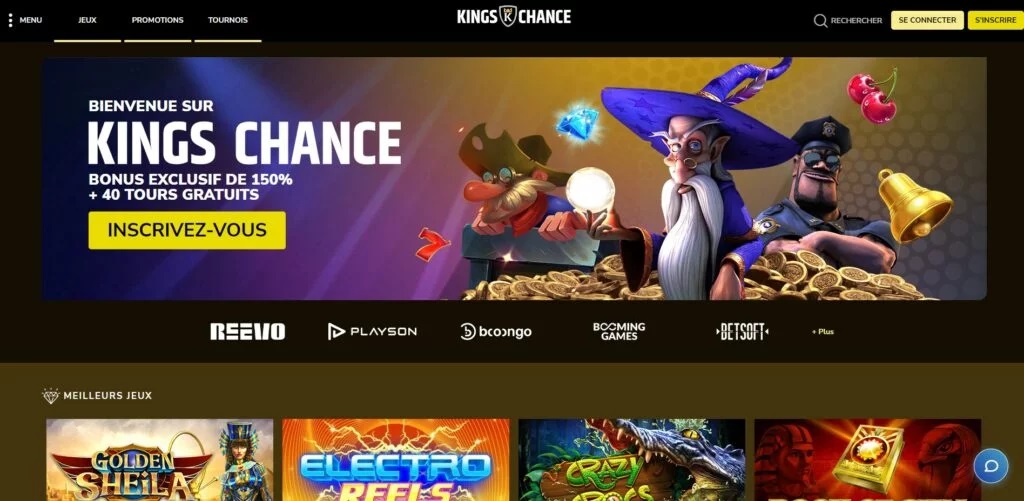

Brief Overview of King Chance Web Casino

In the vast world of online casinos, King Chance Web Casino shines as a captivating destination for both new and seasoned gamblers. This comprehensive article aims to unveil the hidden treasures, covering everything from exclusive bonuses such as King Chance Web Casino free chip, demo games, download options, deposit methods, and an exploration of what lies beyond the gaming tables. Whether you’re a curious newcomer or a seasoned player, this guide will provide invaluable insights into King Chance Web Casino’s offerings. read more

Comments Off on The $100 No Deposit Bonus Codes: A Rare Gem

The $100 No Deposit Bonus Codes: A Rare Gem

$100 no deposit bonus Australia is a special treat for casino players. It’s like getting free money to play with, and that’s pretty rare. These bonuses are offered by online casinos to attract new players and keep existing ones happy. What makes $100 no deposit bonus codes 2024 special is their value, giving you a decent chance to win without risking your own cash. Finding these codes can be a bit tricky, but reputable casinos have them. Once you get a code, you can use it to play games, and if you’re lucky, you might even win. Just remember to…

Comments Off on Unlocking Excitement: No Deposit Bonus Codes for Australian Online Casinos in 2022

Unlocking Excitement: No Deposit Bonus Codes for Australian Online Casinos in 2022

Welcome to the world of Australian online casinos 2022, where you can kickstart your gaming adventure without spending a dime. No deposit bonus codes open the doors to exciting sign-up rewards and more. These codes are like gifts from the casino, offering you a risk-free opportunity to try your luck and win real money. Whether you’re a seasoned player or new to online casinos, our guide will show you how to find the best casino no deposit bonus codes, the different types of bonuses available, and tips on maximizing your chances of winning. Get ready to embark on an exhilarating…